Projekta nosaukums latviski: Dinamisko sistēmu struktūru saglabājošie neironu tīkli

Projekta nosaukums angliski: Structure-preserving neural networks of dynamical systems

Projekta numurs: lzp-2020/2-0267

Projekta īstenotājs: Latvijas Universitāte (LU)

Projekta vadītājs: Dr. math. Jānis Bajārs

Projekta īstenošanas vadošā struktūrvienība LU ir Fizikas, matemātikas un optometrijas fakultāte

Projekta īstenošanas periods: 01.12.2020.–31.12.2021.

Projekta kopējais finansējums: 100 389 EUR

Apraksts latviešu valodā

Dinamiskās sistēmas spēlē lielu lomu dažādu fizikālu, kā arī tehnoloģisku procesu modelēšanā. Dinamisko sistēmu teorija ir viens no galvenajiem izpētes objektiem lietišķajā matemātikā. Ņemot vērā nepārtraukti augošo datu pieejamību, kurus iegūst no novērojumiem vai laboratorijas eksperimentiem, vai skaitliskajiem aprēķiniem, viena no mūsdienu procesu modelēšanas dominējošām metodēm ir neironu tīkli, kas spēj efektīvā veidā aprakstīt ļoti sarežģītas funkcijas. Var apgalvot, ka mūsdienās neironu tīklu pielietošana un attīstīšana ir viens no vadošajiem prospektiem jaunāko tehnoloģiju izstrādē. Šī projekta ietvaros tika konstruēti neironu tīkli, kas labāk un efektīvāk spēj aprakstīt un prognozēt specifiskus dinamiskos procesus, tai skaitā tika izstrādāti dziļi ģeneratīvie modeļi jaunu molekulu atklāšanai.

Projekta ietvaros tika plānots izstrādāt līdz divām zinātniskajām publikācijām, piedalīties starptautiskās konferencēs, veikt zinātniskos seminārus un par projekta saistošām tēmām informēt jaunos matemātiķus A. Liepas Neklātienes matemātikas skolas Mazās matemātikas universitātē (MMU). Projekta realizācija ir veicinājusi vadošo pētnieku un iesaistīto studentu profesionālo izaugsmi un lietišķās matemātikas un skaitlisko metožu izstrādes attīstību Latvijas Universitātes Fizikas, matemātikas un optometrijas fakultātē.

Pēdējā laikā liela uzmanība tiek pievērsta struktūru saglabājošiem neironu tīkliem, proti, dinamisko sistēmu, jo īpaši, Hamiltona dinamikas, iedvesmotām neironu tīklu arhitektūrām. Ir labi zināms, ka Hamiltona dinamikai piemīt daudz ģeometrisku īpašību, piemēram, enerģijas nezūdamība, simplektiskums un tilpuma saglabāšanās fāzu telpā, kā arī to atrisinājumi ir laikā atgriezeniski. Simplektiskumu, kas ir viena no būtiskākajām Hamiltona dinamikas plūsmas īpašībām, var eleganti uzdot neironu tīkliem, kurus var uzskatīt par dažādu attēlojumu kompozīciju, pielāgojot šiem attēlojumiem šo strukturālo īpašību un paļaujoties uz to, ka simplektisku attēlojumu kompozīcija ir arī simplektisks attēlojums. Neironu tīkli ar iebūvētām struktūrām var atrisināt ieilgušas problēmas, kas saistītas ar dziļo mašīnmācīšanos, piemēram, datu plūsmas stabilitāti, kā arī gradienta eksplodēšanas un samazināšanās problēmas. Turklāt, ir jau nodemonstrēts, ka šādu neironu tīklu apmācībai ir nepieciešams mazāks apjoms apmācības datu un tie sniedz kvalitatīvi labākas prognozes par regulāriem neironu tīkliem. Šie apsvērumi arī kalpoja par galveno motivāciju izstrādāt šo projektu un veicināt pētījumus šajā jomā.

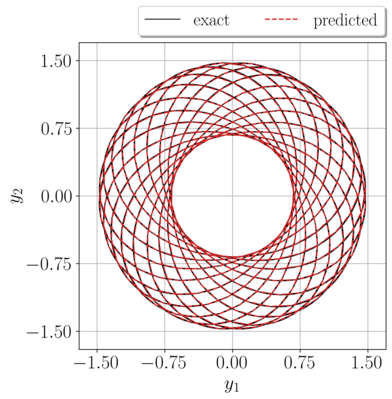

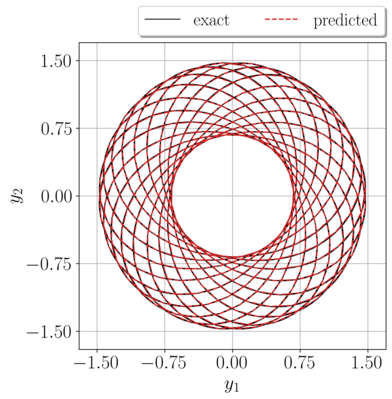

Hamiltona dinamika, kas ir simplektiska, ir arī tilpuma saglabājoša fāzu telpā. No otras puses, vispārīgas dinamiskās sistēmas, kas ir tilpuma saglabājošas, it īpaši, nepāra dimensiju sistēmas, nav simplektiskas. Tādējādi, simplektiski neironu tīkli, kas izstrādāti pāra dimensiju sistēmām, nav piemēroti šādas dinamikas apguvei. Šajā projektā mēs izstrādājām lokāli simplektiskus neironu tīklus LocSympNets, lai apgūtu tilpuma saglabājošo dinamisko sistēmu atrisinājumus. Šī darba rezultātā ir izstrādāti invertējami lokāli simplektiski gradienta moduļi, kuru kompozīcija veido tilpuma saglabājošus neironu tīklus, tas ir, LocSympNets. Lai vēl vairāk iekļautu dinamiskās sistēmas plūsmas īpašības neironu tīklu struktūrā, mēs vispārinājām LocSympNets, izstrādājot simetriskus neironu tīklus SymLocSympNets, kuru inversais attēlojums ir vienāds ar SymLocSympNets, ņemot negatīvu laika soli. LocSympNets un SymLocSympNets tiek pētīti skaitliski, apgūstot atrisinājumus lineārām un nelineārām tilpumu saglabājošām dinamiskām sistēmām. Šādi neironu tīkli tika veiksmīgi pielietoti Eilera vienādojuma periodisku atrisinājumu prognozēšanai, kā tas ir redzams 1. attēlā.Turklāt, 2. attēlā ir redzams, ka neironu tīkls spēj prognozēt ar augstu precizitāti kvazi-periodisku atrisinājumu lādētas daļiņas kustībai elektromagnētiskā laukā.

Zinātniskie rezultāti ir nopublicēti starptautiskā (Q1, Scopus indeksētā) žurnālā: Journal of Computational Physics (DOI: 10.1016/j.jcp.2023.111911), ar nosaukumu “Locally-symplectic neural networks for learning volume-preserving dynamics”. Programmas kodi būs brīvi pieejami mājas lapā GitHub. Publikācijas priekšdruka ir pieejama mājas lapā arXiv.org

- Invertējami lokāli simplektiski neironu tīkla gradienta moduļi.

- Jauni neironu tīkli LocSympNets un SymLocSympNets, lai apgūtu tilpuma saglabājošu dinamiku.

- LocSympNets un SymLocSympNets spēj apgūt lineāru un nelineāru tilpuma saglabājošu dinamiku.

- Tilpuma saglabājošie neironu tīkli LocSympNets un SymLocSympNets dod augstas precizitātes prognozes.

Papildus jau izstrādātajiem neironu tīkliem LocSympNets mēs esam pievērsuši uzmanību jautājumam par optimālām moduļu kompozīcijas un parametru stratēģijām. Skaitliskie eksperimenti liecina, ka nezināmo mainīgo mijiedarbība starp neironu tīkla slāņiem ir būtiska, lai korekti apgūtu dinamiku. Iegūtie rezultāti tika prezentēti starptautiskā konferencē XIII Baltkrievijas matemātikas konference un publicēti konferences rakstu krājumā ar nosaukumu “Optimālas parametru kombinācijas tilpuma saglabājošiem neironu tīkliem”. Struktūru saglabājošu neironu tīklu arhitektūras var sīkāk pētīt no analītiska un skaitļošanas viedokļa un ar dažādiem pielietojumiem. Turpmākie pētījuma virzieni ietver struktūru saglabājošu neironu tīklu izstrādi parciāliem diferenciālvienādojumiem, piemēram, Hamiltona vai multisimplektiskiem parciāliem diferenciālvienādojumiem. Turklāt, LocSympNets algoritmi vēl nav pielietoti un testēti klasifikāciju un normalizējošu plūsmu problēmām.

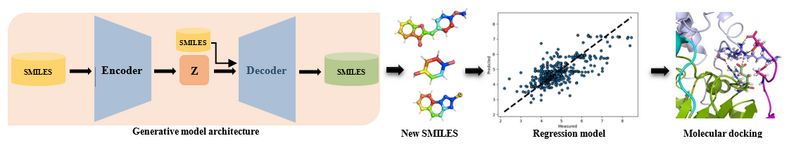

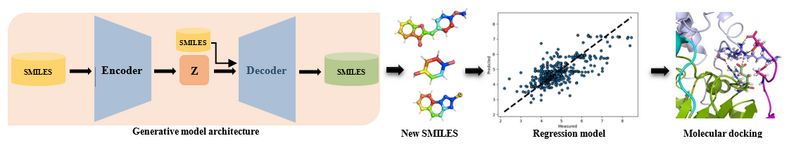

Pēdējos gados nozīmīgu nozīmi ir ieguvuši dziļie ģeneratīvie modeļi (DGMs). DGMs modelē apmācības datu varbūtības sadalījumu un ģenerē jaunus datus, ņemot paraugus no apgūtā datu sadalījuma. Ģeneratīvie modeļi ir uzrādījuši ļoti labus rezultātus dažādās pielietojuma jomās, piemēram, attēlu, teksta un runas ģenerēšanā. DGMs tiek arī izmantoti, lai atrisinātu ilgstošo un izaicinošo jaunu zāļu dizaina problēmu, un tā ir viena no populārākajām pieejām jaunu molekulu atklāšanai jeb ģenerēšanai. Šajā darbā mēs esam izstrādājuši dziļi ģeneratīvu modeli, kura pamatā ir variācijas automātiskais kodētājs. 3. attēlā ir parādīts izmantotās metodoloģijas modelis un grafiskais attēlojums jaunu molekulu atklāšanai.

Ģeneratīvajā modelī mēs izmantojam SMILES virknes, lai raksturotu molekulas. Lai kodētu un atšifrētu SMILES virknes, mēs esam aplūkojuši DGM ar trīs rekurentu neironu tīklu arhitektūrām: RNN, LSTM un GRU. Lai nodemonstrētu mūsu metodes efektivitāti, mēs aplūkojām divu veidu molekulu datu kopas, tas ir, unikālās (SIRT1 un p450) un dažādās (visas zāļu bankas molekulas). Tika pētītas visu trīs metožu optimālās apmācības stratēģijas un skaitļošanas efektivitāte. Visām trim metodēm ģenerētie SMILES tiek pārbaudīti, izmantojot regresijas modeli. Šajā pētījumā MACCS pirkstu nospiedumi tika izmantoti kā līdzekļi mašīnmācīšanās regresijas modeļu izstrādei. Augstākā ranga molekulas tiek tālāk apstiprinātas, izmantojot, piemēram, molekulāro dokstaciju. Mūsu rezultāti parāda, ka no visiem trim DGMs modelis ar GRU bija visefektīvākais algoritms apmācībā, kā arī deva vislielāko skaitu jaunu daudzveidīgu un mērķa specifiskus SMILES ar labu bioloģisko aktivitāti. Turklāt, jaunradītās molekulas ir ļoti viegli sintezējamas laboratorijas apstākļos. Mūsu darba rezultāti būtiski veicina de novo molekulāro atklājumu un dizaina jomu un paver jaunas perspektīvas turpmākam darbam un sadarbībai šajā daudznozaru pētniecības jomā. Turpmākais darbs ir saistīts ar tādu DGM izstrādi, kas ietver dinamikas struktūru saglabājošus rekurentus neironu tīklu arhitektūras, piemēram, UnICORNN, lai risinātu problēmas ar ļoti garām atkarībām datos. Šī daudznozaru pētījuma perspektīvas ir plašas. Papildus struktūru saglabājošo DGM izpētei molekulu atklāšanai, mēs varam arī paplašināt izstrādāto modeli, lai iekļautu noteiktus papildus nosacījumus jaunu molekulu atklāšanā.

Kopsavilkumā, šī projekta svarīgākie rezultāti ir lokāli simplektisku neironu tīklu LocSympNets izstrāde, lai apgūtu tilpuma saglabājošu dinamiku, un dziļi ģeneratīvs modelis jaunu molekulu atklāšanai. Tika parādīts, ka izstrādātais uz datiem virzīts algoritms spēj ar augstu precizitāti apgūt tilpuma saglabājošu dinamiku un dot augstas precizitātes prognozes. No otras puses, izstrādātais dziļais ģeneratīvais modelis var ģenerēt jaunas molekulas ar lielu bioloģisko aktivitāti, kuras ir ļoti viegli eksperimentāli sintezēt. Ņemot vērā, ka molekulārā telpa ir ārkārtīgi plaša, diskrēta un nesakārtota, DGM izstrāde ir ļoti daudzsološa pieeja. Tādējādi, šī projekta rezultāti ir aktuāli dinamisko sistēmu teorijai, lietišķās un skaitļošanas matemātikas pētījumiem, inženierzinātņu un datu zinātnes nozarēm, kā arī rūpnieciski nozīmīgiem ķīmijas un bioloģijas pētījumiem, lai radītu jaunus savienojumus un zāļu dizainu.

Zinātniskie rezultāti tika prezentēti divās starptautiskās konferencēs:

- XIII Baltkrievijas matemātikas konference, 2021. gads, 22.–25. novembris, ar referāta nosaukumu “Optimālas parametru kombinācijas tilpuma saglabājošiem neironu tīkliem”.

- LU 80. starptautiskā zinātniskā konference, 2022. gada 4. februārī, sniedzot FMOF plenārsēdes prezentāciju ar nosaukumu "Dinamisko sistēmu iedvesmoti neironu tīkli".

Papildus zinātniskajām konferencēm mēs piedalījāmies arī 10. seminārā par sākuma nosacījumu problēmu paralēlam skaitļošanas metodēm (PinT 2021), 2021. gads, 2.–6. augusts, lai uzzinātu vairāk par paralēlām skaitļošanas metodēm, uz kuru bāzes ir veidoti Parareal neironu tīklu algoritmi.

Papildus regulārām iknedēļas grupas sanāksmēm, mēs rīkojām tiešsaistes starpdisciplināru lietišķās matemātikas semināru, kurā ar prezentācijām uzstājās:

- Docents Dr. Jānis Lazovskis (RTU Rīgas Biznesa skola, Latvija), “Neighborhoods for classifying binary dynamics in directed networks with machine learning”, 2021. gada 5. februārī.

- Dr. Charuvaka Muvva (BiomAILS (INDIA) PVT LTD, Hyderabad, INDIA), “Computational Studies on Structure, Dynamics and Binding of Inhibitors with Proteins Involved in Age-related Diseases”, 2021. gada 26. februārī.

- Docents Dr. Jānis Bajārs (Latvijas Universitāte, Latvija), “Volume-preserving dynamical systems and numerical methods”, 2021. gada 28. maijā.

- Docents Dr. Xiaocheng Shang (University of Birmingham, UK), “Structure-preserving integrators for dissipative systems based on reversible-irreversible splitting”, 2021. gada 29. jūlijā.

Lai informētu jaunos matemātiķus ar projektu saistītām tēmām, mēs piedalījāmies Mazā matemātikas universitātē ar izglītojošu (tiešsaistes) lekciju “Uz ģeometriskām īpašībām balstīta skaitliskā modelēšana”, 2021. gada 6. martā.

Šis projekts ir apvienojis pētniekus no lietišķās un skaitļošanas matemātikas un skaitļošanas bioloģijas ar mašīnmācības kopienu. Lai nodrošinātu Latvijas Universitātē pētniecības virziena nepārtrauktību, projektā tika iesaistīti studenti. Studenti bija iekļauti zinātniskās darba veikšanā, tostarp, ņēma dalību organizētajos starptautiskajos pētniecības semināros. Studenti apguva un ieguva teorētiskus pamatus par ģeometrisku struktūru saglabājošām dinamiskajām sistēmām, tai skaitā skaitliskajām metodēm, uz datiem virzītām metodēm un mašīnmācīšanās algoritmiem. Turklāt, viņi uzlaboja savas praktiskās programmēšanas iemaņas programmēšanas valodās MATLAB un Python, izmantojot NumPy, scikit-learn un PyTorch, tas ir, dinamisko sistēmu, skaitlisko metožu un mašīnmācīšanās algoritmu bibliotēkas. Daniels Markauss projekta ietvaros izstrādāja bakalaura darbu ar nosaukumu Hamiltona sistēmu risināšanas un mācīšanās struktūru saglabājošie algoritmi. Projektā iesaistītie pētnieki uzlaboja savas programmēšanas prasmes, izmantojot Python mašīnmācīšanās algoritmus, un ieguva padziļinātas matemātiskās zināšanas lineārā algebrā, optimizācijas un aproksimācijas teorijā, diferenciālvienādojumos, un neironu tīklu matemātiskajos pamatos.

Šī projekta pētniecības aktivitātes ir devušas tiešus ieguvumus studiju videi Latvijas Universitātē. 2021. gada laikā tika izstrādāta jauna matemātikas maģistra studiju programma, kas ietver trīs specializācijas: Datu zinātne, Tehnoloģiju matemātika un Tīrā matemātika. Papildus jau esošajiem kursiem tika izstrādāti divi jauni kursi specializācijā Tehnoloģiju matemātika, ko izstrādāja projekta vadītājs Dr. Jānis Bajārs, tas ir, Dinamiskās sistēmas un Datu virzīti skaitliskie algoritmi, kas stimulēs turpmāku dinamisko sistēmu teorijas un datu virzītu metožu attīstību, kā arī daudzdisciplināru domāšanu.

Description in English

Dynamical systems play a major role in modeling various physical and technological processes. The theory of dynamical systems is one of the main study subjects in applied mathematics. Because of the constantly growing availability of data obtained from observations, laboratory experiments, or numerical calculations, neural networks are one of the predominant contemporary modeling methods that can effectively describe complex functions. It can be argued that the use and evolution of neuron networks are leading prospects for the development of emerging technologies. As part of this project, neuron networks were designed to better and more effectively describe and predict specific dynamics, and deep generative models were developed for novel lead molecule discovery.

Within the project, we planned to deliver up to two scientific publications, participate in international conferences, carry out scientific seminars, and inform young mathematicians of the project's binding topics at the Small Mathematics University (MMU). Implementation of the project has significantly contributed to the professional growth of the involved researchers and students and the development of applied and computational mathematics disciplines at the Faculty of Physics, Mathematics and Optometry of the University of Latvia.

Recently structure-preserving neural networks, that is, dynamical systems, in particular, Hamiltonian dynamics-inspired neural network architectures, have received high attention. Hamiltonian dynamics are known to have rich geometric properties, such as energy conservation, symplecticity and phase volume preservation, and time reversibility. Symplecticity, being one of the most fundamental properties of the flow of Hamiltonian dynamics, can elegantly be extended to neural networks, which can be viewed as a composition of maps, by imposing this structural property on these maps and relying on the fact that the composition of symplectic maps is also symplectic. Neural networks with built-in structures may resolve and address long-standing problems in deep learning, such as the stability of feed-forward propagation and exploding and vanishing gradient problems. In addition, such neural networks have been shown to require less amount of training data, generalize better than regular neural networks, and have superior or on-par state-of-the-art performance. These considerations and the high success of geometric numerical integration were also the main motivation to propose this project and advance research in this area.

Hamiltonian dynamics, being symplectic, are also phase volume-preserving. On the other hand, general volume-preserving dynamical systems, especially of odd dimension, are not symplectic. Thus, symplecticity-preserving neural networks developed for even-dimensional systems are not applicable to learning such dynamics. Thus, in this project, we proposed locally-symplectic neural networks LocSympNets for learning phase volume-preserving dynamics. This work has been inspired by the recent work on symplecticity-preserving neural networks for learning the flow of Hamiltonian dynamics and volume-preserving numerical splitting methods based on the local Hamiltonian description of the divergence-free vector fields. The novelty of the work consists of proposing locally-symplectic gradient invertible modules, which composition leads to volume-preserving neural networks, that is, LocSympNets. To further preserve properties of the flow of a dynamical system LocSympNets are extended to symmetric locally-symplectic neural networks SymLocSympNets, such that the inverse of SymLocSympNets is equal to the feed-forward propagation of SymLocSympNets with the negative time step, which is a general property of the flow of a dynamical system. LocSympNets and SymLocSympNets are studied numerically considering learning linear and nonlinear phase volume-preserving dynamics. Such neural networks were successfully applied to the Euler equations of the motion of a free rigid body, as illustrated in Figure 1, where the network was able to learn rigid body dynamics to high accuracy, including both conserved quantities, that is, the kinetic energy and quadratic invariant. Whereas, in Figure 2, we illustrate predictions of quasi-periodic solution of the charged particle motion in an electromagnetic field.

Mathematical details of the proposed phase volume-preserving neural networks LocSympNets and SymLocSympNets can be found in the published (Q1, Scopus indexed) Journal of Computational Physics (DOI: 10.1016/j.jcp.2023.111911) article titled “Locally-symplectic neural networks for learning volume-preserving dynamics”. The numerical codes will be freely available on GitHub. In addition, a preprint can be found on arXiv.org

- Invertible locally-symplectic neural network gradient modules.

- Novel neural networks LocSympNets and SymLocSympNets for learning phase volume-preserving dynamics.

- LocSympNets and SymLocSympNets can learn linear and nonlinear phase volume-preserving dynamics.

- Volume-preserving neural networks LocSympNets and SymLocSympNets produce accurate long-time predictions.

In addition to the proposed networks LocSympNets we have addressed the question of optimal composition strategies. Numerical experiments indicate that coupling of the state variables between neural network layers is essential for learning dynamics. Obtained results were presented at the international conference XIII Belarusian Mathematical Conference, and published in the conference proceedings, titled “Optimal parameter combinations for volume-preserving neural networks”. Structure-preserving neural network architectures can be further explored from an analytical and computational point of view and with diverse applications. Potential extensions include the development of structure-preserving neural networks for PDEs, e.g., Hamiltonian or multi-symplectic PDEs. In addition, LocSympNets have not yet been tested for classification problems and learning normalizing flows.

In recent years the developments of deep generative models (DGMs) have gained significant importance. DGMs attempt to learn the probability distribution of the training data by extracting representative features and producing a low-dimensional representation, ultimately generating new data by sampling from the learned data distribution. Generative models have shown very good results in different application areas, such as the generation of images, text, and speech, to mention but a few. The development of DGMs has also carried over to resolve the long-standing and challenging problem of drug design and is one of the most favored approaches for discovering and designing new molecules. In this work, we have designed a generative model based on the variational autoencoder. Figure 3 demonstrates the model and graphical representation of the used methodology for novel molecule discovery.

We consider SMILES string representation of molecules. To encode and decode SMILES we have considered three multi-layer recurrent neural network architectures: Elman (RNN), long short-term memory (LSTM), and gated recurrent unit (GRU). To validate our method, we have selected and tested two types of data sets, that is, unique (target specific inhibitors (SIRT1 and p450)) and diverse (all drug bank molecules). Optimal training strategies and computational efficiency of all three methods were investigated. For all three methods generated SMILES are screened on the regression model. In this study, MACCS fingerprints were used as the features to develop machine learning regression models. The top-ranked molecules are further validated using structure-based ranking approaches such as molecular docking to study molecular-level interactions. Our results demonstrate that from all three DGMs, the model with GRU was the most efficient algorithm in training as well as in producing the largest number of new diverse and target-specific SMILES with good biological activity. In addition, the generated molecules are very easy to synthesize in laboratory conditions. The results of our work significantly contribute to the field of de novo molecular discovery and design and open new perspectives for future work and collaborations in this multidisciplinary research area. Future work concerns the development of DGMs incorporating dynamics structure-preserving recurrent neural network architectures, for example, UnICORNN, for problems with very long dependencies. The prospects in this multidisciplinary research are vast. Apart from investigating structure-preserving DGMs for molecule discovery, we may also extend our model to target molecule discovery and design by imposing additional conditions.

In conclusion, the most important results of this project are the development of locally-symplectic neural networks LocSympNets for learning phase volume-preserving dynamics and a deep generative model for novel lead molecule discovery. It was demonstrated that the developed data-driven algorithm can learn phase volume-preserving dynamics and the system’s additional invariants with high accuracy and was able to produce long-time predictions. On the other hand, the developed generative model can generate new molecules with high biological activity, which are experimentally very easy to synthesize. Considering that a molecular space is extraordinarily vast, discrete, and disorganized this is a very promising approach. Thus, this project's results are important to the research in applied and computational mathematics of dynamical systems, and to engineering and data science communities, as well as to chemistry and biology with industrial significance to generate novel lead compounds and drug design.

To reach the scientific communities we exploited traditional means of scientific publications and international conferences. We participated in two international conferences:

- XIII Belarusian Mathematical Conference, November 22-25, 2021, a talk titled “Optimal parameter combinations for volume-preserving neural networks”.

- 80th International Scientific Conference of the University of Latvia, February 4, 2022, by giving a FMOF plenary talk titled “Dynamical systems inspired neural networks”.

In addition to the scientific conferences, we also participated in the 10th Workshop on Parallel-in-Time Integration (PinT 2021), August 2-6, 2021, to learn more about parallel-in-time methods, motivated by the recent works on the Parareal neural network algorithms.

Apart from regular weekly group meetings we held an online Interdisciplinary Applied Mathematics Seminar and had invited talks:

- Assistant Professor Dr. Jānis Lazovskis (RTU Riga Business School, Latvia) with a talk titled “Neighborhoods for classifying binary dynamics in directed networks with machine learning”, February 5, 2021.

- Dr. Charuvaka Muvva (BiomAILS (INDIA) PVT LTD, Hyderabad, INDIA) with a talk titled “Computational Studies on the Structure, Dynamics and Binding of Inhibitors with Proteins Involved in Age-related Diseases”, February 26, 2021.

- Assistant Professor Dr. Jānis Bajārs (University of Latvia, Latvia) with a talk titled “Volume-preserving dynamical systems and numerical methods”, May 28, 2021.

- Assistant Professor Dr. Xiaocheng Shang (University of Birmingham, UK) with a talk titled “Structure-preserving integrators for dissipative systems based on reversible-irreversible splitting”, July 29, 2021.

To reach the General public we participated at the Small Mathematics University with an educational (online) talk “On geometric properties based numerical modeling”, March 6, 2021.

This project has brought together researchers from applied and computational mathematics and computational biology with the community of machine learning. To ensure the continuity of the research field at the University of Latvia we involved students in the project. Students were immersed in scientific activities, including participation in international research seminars. Students learned and gained theoretical foundations of geometric structure-preserving dynamical systems, numerical methods, data-driven methods, and machine learning algorithms. In addition, they improved their practical programming skills in MATLAB and Python using NumPy, scikit-learn and PyTorch libraries of dynamical systems, numerical methods, and machine learning algorithms. Within the project, a bachelor thesis by Daniels Markauss was written titled Structure-preserving algorithms for solving and learning Hamiltonian systems. Involved researchers benefited greatly from improving their programming skills in machine learning algorithms in Python and mathematical knowledge of subjects such as linear algebra, optimization and approximation theory, differential equations, and underpinning mathematics of neural networks.

The research activities of this project have brought direct benefits to the study environment. Within 2021 the new Master’s degree program in Mathematics was developed at the University of Latvia containing three specializations: Data Science, Technology Mathematics, and Pure Mathematics. In addition to already existing courses, two new modules in the specialization Technology Mathematics were developed by the project leader Dr. Jānis Bajārs, that is, Dynamical Systems course and Data-Driven Numerical Algorithms, which will stimulate further developments in the areas of dynamical systems and data-driven methods and will encourage multidisciplinary thinking.

Academic Centre

Academic Centre